隨著人工智慧(AI)技術的成熟,影像辨識應用在各行各業快速普及,無論是自駕車視覺系統、人臉辨識門禁、安全監控,乃至醫療影像分析,皆大幅提升效率與準確性。然而,這些系統也面臨日益嚴重的對抗樣本攻擊(Adversarial Attacks)風險,對於AI影像評測與部署的安全性構成重大挑戰。

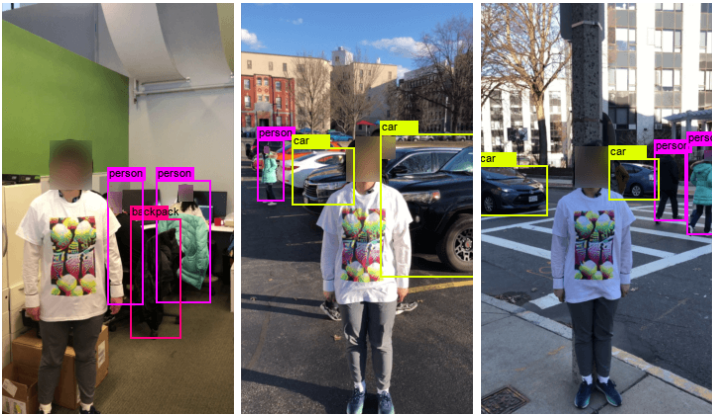

對抗樣本是指攻擊者在輸入影像中加入肉眼難以察覺的微小擾動,使AI模型產生錯誤判斷。例如,自駕車系統可能將被改動過的「停車標誌」誤認為「限速標誌」,進而導致危險決策。此類攻擊不僅存在於數位資料中,近期研究更證實對抗樣本可被實體化,例如印製帶有擾動圖案的衣物,足以欺騙目標偵測系統。

為因應此威脅,AI影像評測逐漸納入「對抗樣本防禦能力」的測試標準。目前主流防禦技術包括:對抗訓練(將對抗樣本納入訓練資料)、輸入預處理(降低擾動效果)及異常樣本偵測模組等。

另一方面,國際間對AI安全監管也逐漸成形,歐盟、NIST與MITRE等機構紛紛推出AI風險管理框架與對抗威脅對應指南,例如MITRE的ATLAS框架就明列多項AI攻擊技術,成為評估AI影像系統風險的重要依據。企業若忽視模型安全性,在進軍國際市場時可能遭遇法規與信任障礙。

AI影像系統的安全評測不再只是檢驗準確率,更需納入對抗樣本的防禦與風險應對能力。未來AI若要廣泛應用於高風險場景,建構具韌性且符合法規要求的模型架構將是成功的關鍵。然而,對抗樣本具備跨模型遷移性與高隱蔽性,使現有防禦技術在實際場域中仍面臨準確率與效率之平衡難題。