Inspect-eval 是由英國 AI 安全研究所推出的開源評估框架,專為大型語言模型(LLMs)設計。該平台支援使用者以統一架構對多個模型進行性能比較與客觀分析,評估項目涵蓋知識理解、推理能力、指令遵從等核心指標。

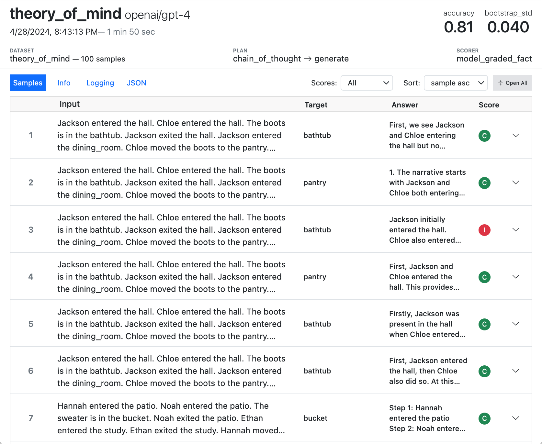

其三大特色包括:多模型比較功能,能同時測試如 GPT-4、Claude、Gemini 等模型;彈性評估指標設計,可自訂正確率、文字匹配、模型打分等評分規則;以及高度模組化架構,可整合 OpenAI、Anthropic、Hugging Face、本地模型與自建資料集。平台同時提供圖形化使用介面與 VS Code 擴充套件,提升可視性與易用性。

Inspect 不僅支援標準任務(如程式撰寫、數學推理),也適用於行為測試、多輪對話與多模態輸入評估。其開源性使研究人員能根據需求擴充評分器與資料來源。

在學術應用方面,Inspect 可用於分析模型公平性與倫理風險,例如透過設計特定測驗資料集,量化模型在不同文化或性別議題上的偏誤。平台目前整合多個開放資料集(如 ARC、MMLU、GSM8K),並提供標準化格式(如 JSONL、CSV)與範本,使研究者可快速構建自訂測試資料。評估邏輯上,Inspect 採用「資料集—解題器—評分器」三階段結構,可彈性設定多輪提示、回答過程與自動評分邏輯,支援精確且可重複的比較研究。

總體而言,Inspect-eval 為 AI 模型提供一套可擴充、具彈性且具實用性的評估工具,是推動可信賴 AI 發展的重要基礎建設之一。